Karush-Kuhn-Tucker Conditions

Die ersten beiden Bedingungen geben an, dass zulässig ist.

Die dritte Bedingung sagt aus, dass sich der Gradient von als Linearkombination der Gradienten der Nebenbedingungen und als konische Kombination (konische Hülle) der Nebenbedingungen schreiben lässt.

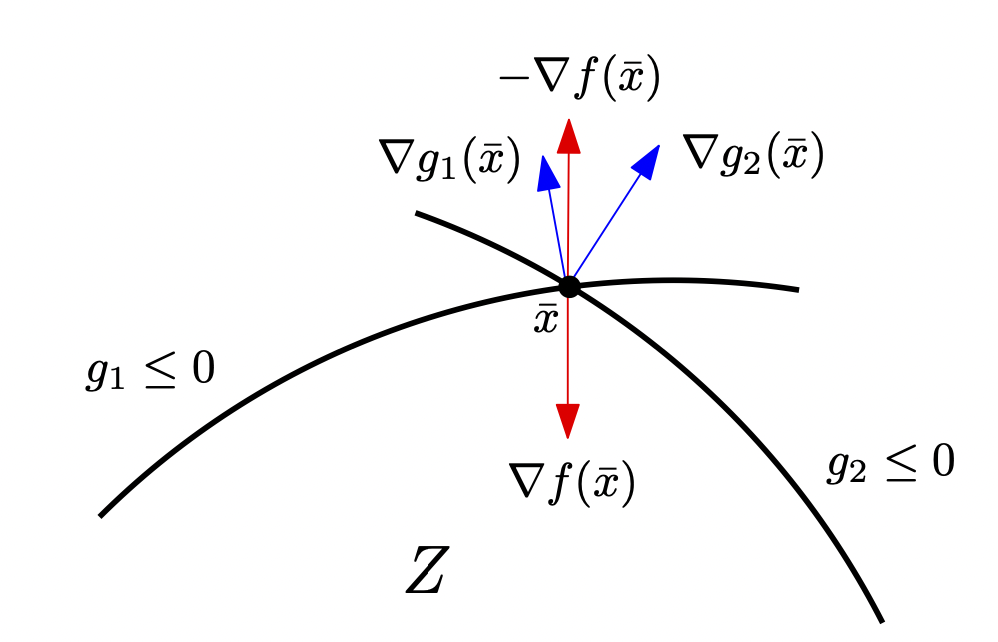

Hier ein Beispiel für die dritte Bedingung. Der negative Gradient liegt im Kegel (konische Hülle) der Nebenbedingungen, somit ist die dritte Bedingung mit bestimmten erfüllt.

Die vierte Bedingung heißt Komplementaritätsbedingung.

und sind Lagrange-Multiplikatoren.

Keine Restriktionen → Notwendige Optimalitätsbedingung erster Ordnung unrestringierter Probleme

Da die kein Vorzeichen haben kann man für die Linearkombination auch schreiben:

Mit der Lagrange-Funktion lässt sich die dritte Bedinung auch als schreiben.

Wenn alle Funktionen zweimal stetig differenzierbar sind lässt sich die Hessematrix bestimmen als:

KKT-Punkte bestimmen

- NLP in die Form bringen mit .

- Gradienten aller Funktionen bestimmen

- Alle Fälle der Indexmenge der Aktiven Ungleichungsbedingungen durchgehen und auf Lagrange-Funktion testen

- Jeweils auf die anderen Bedingungen wie testen

- falls alle Bedingungen gelten → bestimmen

- Mit der Information, dass Ungleichung aktiv ist und dem kann berechnet werden

- Punkt auf Zulässigkeit testen (andere Bedingungen)

- LICQ überprüfen

- Für zwei aktive Ungleichungen können diese kombiniert werden um ein und zu berechnen. → Andere Bedinungen testen

ML4ENG

apply for the given problem:

Based on the last condition or for each training point.

When is not zero, we call the training point a support vector since it is right on the margin.

We can now use our previously derived function to calculate with our newly gained :

Depending on the sign of our result, the datapoint is either in class +1 or -1: